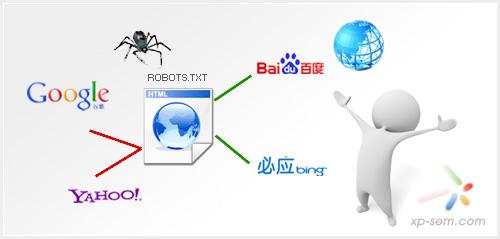

有时因为网站需要,我们的站点内有大量的相似、重复页面,如果被搜索引擎发现一个站点有大量的重复,就会给予惩罚。这是我们就要用到robots文件,用以屏蔽一些类似的页面,另外robots文件也可以帮助我们屏蔽一些个人隐私文件。

网站域名、服务器。

FTP工具。

如何正确撰写robots文件 1、

如果你的站点对所有搜索引擎公开,则不用做这个文件或者robots.txt为空就行。

如何正确撰写robots文件 2、

必须命名为:robots.txt,都是小写,robot后面加"s"。

如何正确撰写robots文件 3、

robots.txt必须放置在一个站点的根目录下。如:通过http://www.zer0v.com/robots.txt 可以成功访问到,则说明本站的放置正确。

如何正确撰写robots文件 4、

一般情况下,robots.txt里只写着两个函数:User-agent和 Disallow。

如何正确撰写robots文件 5、

有几个禁止,就得有几个Disallow函数,并分行描述。

如何正确撰写robots文件 6、

至少要有一个Disallow函数,如果都允许收录,则写: Disallow: ,如果都不允许收录,则写:Disallow: / (注:只是差一个斜杆)。

如何正确撰写robots文件 1、

User-agent: * 星号说明允许所有搜索引擎收录

如何正确撰写robots文件 2、

Disallow: /search.html 说明 http://www.zer0v.com/search.html 这个页面禁止搜索引擎抓取。

使用robots文件还要注意不要屏蔽首页的后缀,比如:index.php、index.html等。

不要写太多的星号,尽量简洁一点,以免误伤。

如果网站上存在一些比较大的文件,比如:打包文件、图片文件、音频视频文件、日志文件等,可以屏蔽掉,以节省宽带。

爱华网

爱华网